智东西7月1日消息,近日,投资管理公司ARKInvest发布一份报告,分析了人工智能技术的发展情况。

通过与摩尔定律的发展历程进行对比,ARK认为,人工智能还处于较早期的阶段。数据显示,目前人工智能的训练成本正以50倍于摩尔定律的速度增长,对于许多用例来说,运行AI推理系统的成本几乎为0。

一、AI计算复杂度每年激增10倍

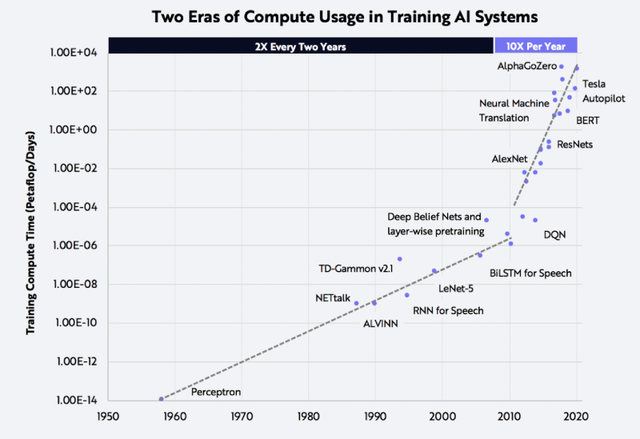

在过去10年中,用于人工智能的训练模型的计算资源激增。在1960到2010年间,人工智能的计算复杂度每两年翻一番。在2010到2020年间,人工智能的计算复杂度每年猛增10倍。

▲1960~2020年间,人工智能计算复杂度变化

报告认为,企业有足够的动力增加对AI的计算资源投入。一方面,这是因为人工智能技术能够带来显著的收入增长;另一方面,用于训练人工智能模型的硬件成本在迅速下降。

实际上,一些超级互联网公司已经开始利用自己掌握的数据训练深度学习网络。目前,这些公司已经在人工智能硬件方面投入了数亿美元的预算。报告预计,随着时间推移,互联网公司会获得更高的回报率。

二、AI模型成本下降:训练成本可低至1美元

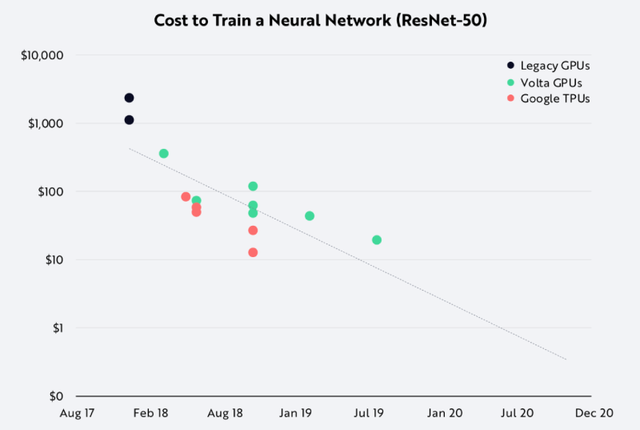

另外,人工智能训练成本约每年下降10倍。例如,2017年,在公有云上训练一个像ResNet-50这样的图像识别网络成本约为1000美元。到了2019年,这项成本降为约10美元。根据报告,按照目前的下降速度,到今年年底,这项成本或将降为1美元。

▲人工智能训练成本呈现下降趋势

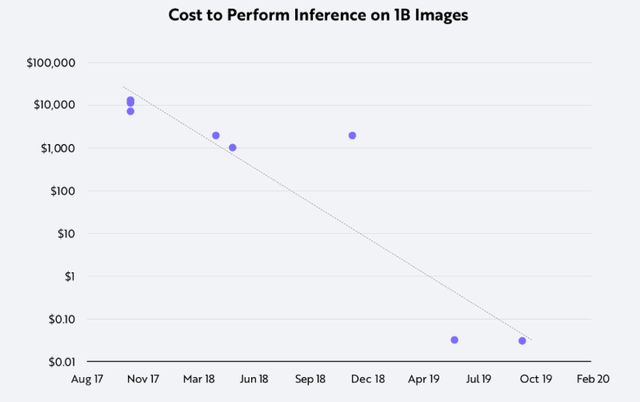

运行一个训练好的神经网络用于推理的成本下降得更快。在过去两年中,分类10亿张图片的成本从10000美元下降到0.03美元。

▲过去两年间,运行神经网络分类10亿张图片的成本呈现下降趋势

三、软件和硬件的突破使成本下降成为可能

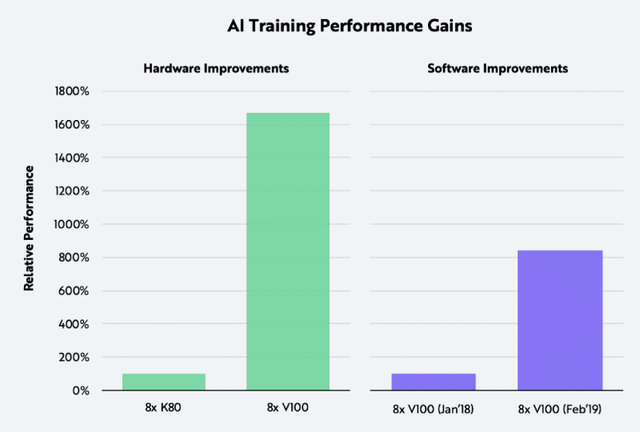

软件和硬件的突破使上述成本下降成为可能。过去3年间,芯片和系统已经进化到可以为深度学习任务添加专用硬件,这带来了16倍的性能提升。如果保持硬件不变,用新版本的AI框架(TensorFlow和PyTorch)与新的训练方法结合,可以产生8倍的性能增益。

▲左–硬件升级带来的性能提升;右–软件升级带来的性能提升

奇怪的是,人工智能训练芯片的成本并未随着单位硬件价格的下降而下降。例如,NVIDIAGPU数据中心经过3次迭代,价格翻了3倍。事实上,自从2017年推出NvidiaV100GPU以来,亚马逊网络服务(AWS)并没有降低过它的价格。

理论上说,AI芯片市场上的竞争有可能驱动NVIDIA降低价格。但实际上,迄今为止还没有玩家能够研发出对NvidiaV100GPU形成威胁的产品。

四、目前还处于早期阶段,2023年市值有望超越互联网

在摩尔定律的第一个10年里,晶体管的数量每年翻一翻。报告指出,鉴于目前人工智能训练和推理的成本在以1/10到1/100的速率下降,人工智能还处于非常早期的阶段,也许在未来几十年里,人工智能会以缓慢的速度保持增长。

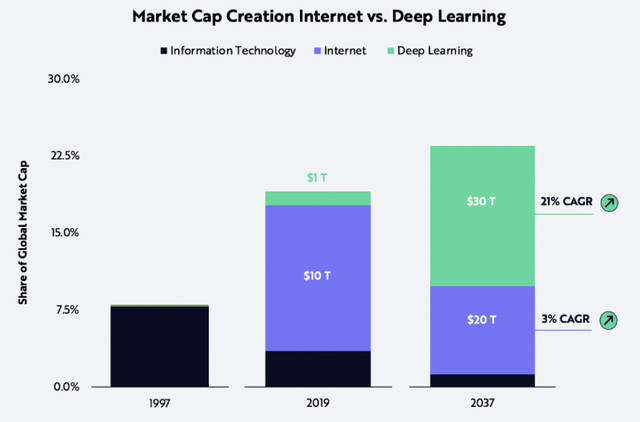

迄今为止,人工智能为全球股票市值增加了约1万亿美元。ARK预计,到2023年,人工智能的股票市值有望达到30万亿美元,人工智能或将成为第一项超越互联网股票市值的技术。

▲2023年,人工智能的股票市值有望达到30万亿美元

结语:与OpenAI研究结果一致

ARKInvest分析了人工智能计算复杂度、训练成本、推理成本、软件和硬件的变化趋势,并与摩尔定律的发展进行对比。数据显示,目前人工智能还处于早期发展阶段。

这项发现与OpenAI的一份报告中得出的结论一致。OpenAI报告显示,自2012年以来,在ImageNet基准测试中,将图像分类AI模型训练到同等性能所需计算量每16个月缩短一半。

要指出的是,虽然训练模型的总体花费在下降,但是在云上开发AI工具还比较昂贵。例如,在最近的一项研究中,华盛顿大学研究团队训练了一个用于检测假新闻的AI模型,在两周的训练时间里,该模型的训练费用达到了25000美元。

文章来源:ARKInvest