近日,英伟达一次性宣布多条与云 GPU 相关的消息。首先,Google 云端平台 (GCP) 的性能将随着NVIDIA P100 GPU 测试版的公开发布获得进一步提升。第二,Google 计算引擎现已普遍采用 NVIDIA K80 GPU。第三,我们很高兴地宣布 K80 和 P100 GPU 均将推出阶梯使用折扣。

云 GPU 可以加快工作负载处理速度,包括机器学习训练和推理、地球物理数据处理、模拟、地震分析、分子建模、基因组学及更多高性能计算用例。

NVIDIA Tesla P100 是前沿 GPU 技术。基于Pascal GPU 架构,您可以通过减少实例来增加吞吐量,同时节省资金。与 K80 相比,P100 GPU 可以让工作负载实现 10 倍提速。

与传统解决方案相比,云 GPU 在灵活性、性能和成本节约三方面做到了优化结合:

灵活性:Google 的自定义虚拟机模型和增量云 GPU 提供的灵活性超高。您可以根据自己的需求自定义 CPU、内存、磁盘和 GPU 配置。

快速性能:云 GPU 采用直通模式,能够提供裸机性能。每个虚拟机最多可以连接 4 个 P100 或 8 个 K80(我们提供最多 4 个 K80 板卡,每个板卡上有 2 个 GPU)。对于那些寻求更高磁盘性能的用户,可选择将最多 3TB 的本地 SSD 连接到任何 GPU 虚拟机。

低成本:使用云 GPU,您可以获得与其余 GCP 资源相同的每分钟计费和阶梯使用折扣。只为您需要的资源付费!

云集成:云 GPU 的供应范围涵盖所有堆栈级别。对于基础架构、计算引擎和容器引擎(仅在Alpha 群集上受支持),您可以使用虚拟机或容器运行 GPU 工作负载。对于机器学习,可以选择性地将云机器学习配置为利用 GPU,从而减少借助TensorFlow大规模培训您的模型所需的时间。

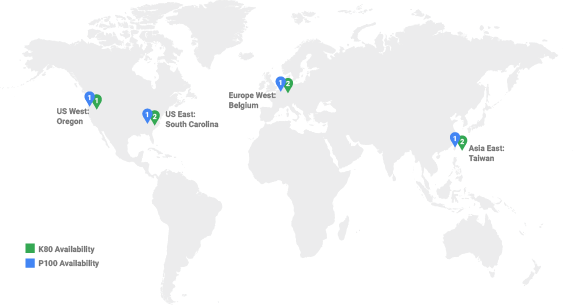

目前全球四个地区已经部署 NVIDIA Tesla P100 和 K80 GPU。并且所有 GPU 都支持阶梯使用折扣:在英伟达的 GPU 运行持续的工作负载时,虚拟机的价格会自动降低(折扣最高 30%)。享受这些折扣无需绑定服务商也无需预付最低费用保证金。

支持云 GPU 的地区 - 多个地区

加快机器学习工作负载速度

自推出 GPU以来,英伟达已经看到用户从 GPU 提供的额外计算性能中获益。得到 GPU 加速的工作负载包括基因组学、计算金融,以及机器学习模型训练和推理等。我们的客户Shazam是在 GCP 上采用 GPU 的首批用户之一,他们采用 GPU 来为音乐识别服务提供支持。

“对于某些任务而言,用 [NVIDIA] GPU 代替传统 CPU 能获得成本效益和性能的提升。GPU 与Shazam核心音乐识别工作负载的相性很好,我们由此将用户录制的音频片段与我们收录了 4000 多万首歌曲的目录相匹配。我们通过拍摄每首歌曲的音频签名,将其编译成自定义数据库格式并将其加载到 GPU 内存中。每当用户通过Shazams发现歌曲时,我们的算法就会使用 GPU 搜索该数据库,直到找到匹配项。每天成功匹配的次数超过 2000 万次。”

- Shazam网站可靠性工程负责人

云 GPU 公告发布让 GCP 又迈进了一步,由此成为所有硬件加速工作负载的理想选择。在 NVIDIA P100 GPU 加入后,英伟达将重点关注帮助您将新的用例带入生活。

微信扫描二维码,关注公众号。