这是从0.1秒到0.005秒的跨越。

近日,中国人工智能“国家队”云从科技宣布,在单帧图像上的人体稠密3D关键点检测技术取得了突破性进展,并同时在3个3D人体数据集Human3.6M、 Surreal和UP-3D上,将原有最低误差记录大幅降低30%,刷新了这一领域的世界纪录。这是继去年云从在3D人脸数据集上大幅刷新纪录后,再一次在此类3D重建技术(此次是人体3D重建技术)取得重要突破。

此次3D人体重建技术的突破,同时在精确度和速度上取得了大幅提升,呈现出来的模型更精细,帧率达到200fps后很多应用都可以实时显示——这将极大地推动相关智能图像应用的落地步伐。颠覆疑犯身份重建、医疗3D打印、虚拟试衣、虚拟化妆、美颜、瘦身、表情姿态动画合成(无需专业设备、呈现工业级电影拍摄效果)等应用场景,帮助大型商场、直播平台、美颜软件、影视特效制作等行业进行智慧化提升。

人体姿态和服饰复杂多样,精度提升意味着对复杂场景的适应性更好,模型更接近真实的情况。如阿凡达、漫威电影、阿丽塔等电影中,都需要专用特效设备与面部贴点来完成精细的人像采集,3D人体(面部)重建算法的精度提升将彻底颠覆电影视频的拍摄制作。

论文中,云从科技针对人体具有丰富多样的姿态和穿着的特点,提出了一套全新的基于人体3D纵深预测的3D信息表征方式。通过对三原色图像(RGB,不含深度信息)的分析,预测人体的3D形态和姿势,并用6万多个点描绘人体,从而在人体重建技术上取得速度与精度的双突破。

从人脸三维重建到人体三维重建

去年,云从研究院曾提出针对人脸的稠密3D关键点技术PRNet,能够基于一帧人脸图像重建出约4万5千个人脸3D关键点,在多个3D人脸数据集上大幅领先之前的技术。相关论文发表于去年的ECCV上,算法在Github社区上进行了开源,已获得超过2600星。

云从科技人脸重建技术

相较于人脸,人体的3D重建更困难:

1-人体具有密闭的3D曲面结构,而不仅仅是一个局部曲面,任何一个角度拍摄的图像都存在约一半的不可见部分;

2-人体的四肢具有更加多变的形态,在3D空间的各个方向上都有更大的纵深,比人脸更加复杂;

3-人体由于穿着的影响,几乎所有情况下都需要解决不同样式服装的遮挡问题,而人脸中的遮挡情况属于少数情况;

4-相对于人脸,人体的3D数据更难以获取,对深度学习技术的使用限制更多

以往的3D人体重建算法往往需要将问题降维,将复杂的人体形态简化到低维的线性间进行表示,从而降低问题的难度。

云从此次提出的3D人体重建算法摆脱了低维线性空间的限制,并设计了一种新型的3D信息表征方式,采用6w多个点表示3D人体,通过卷积神经网络直接预测人体的3D形态和姿态,从而取得了精度和速度上的双重突破。

与传统关键点检测技术的区别

传统的人体关键点检测技术往往以2D的人体骨骼关节点检测形式出现,即通过算法预测RGB图像中人体的十几个关节点的坐标,一方面结果非常稀疏,将人体大为简化成骨骼的形式,另一方面结果往往只包含二维平面上的坐标预测,不能还原深度信息,因此无法体现纵深的感觉。而人体稠密3D关键点检测不仅能输出骨骼关节点信息,更能同时预测大量的人体表面关键点信息,预测结果更加丰富,而且每个点的坐标都是3D的,能够体现不同躯干的纵深信息。

传统关键点与稠密3D关键点对比

与传统3D重建技术的区别

传统的3D重建技术大多需要连续的图片序列或是多视角的图片,在硬件设备上一般需要采用双目摄像头或者结构光设备等深度摄像头,因此在手机等便携设备上往往难以实现;另一方面,深度摄像头还会增加生产成本,增加大面积部署3D重建技术的难度。

基于单帧RGB图像的3D重建任务对原始图像的需求放松的同时,对背后的技术提出了更难的挑战:算法需要从一张彩色图片中推理出人体或人脸的3D形态,并通过【光学透视】【阴影叠加】等基本光学原则准确预测出各个关键点在3D空间的位置和朝向,从而得到人体的姿态或表情信息。

由于对输入图像的要求低,使3D重建技术将可以利用普通光学摄像头作为感知机具。将来该技术将会使美颜APP同时具备高精准度的瘦身功能;商场内试衣魔镜将会自动生成你所想要更换的衣服,大大节省商场空间的同时提升用户体验度。使更多智能应用成为可能。

自然场景的人体3D重建技术应用

领跑三大权威榜单

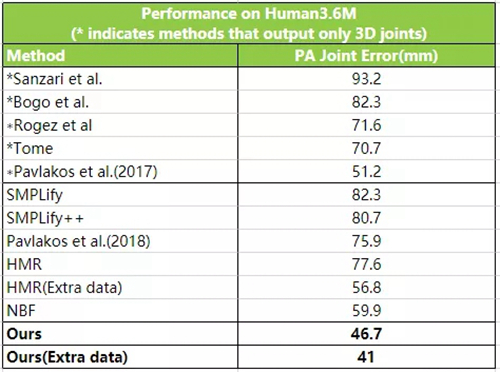

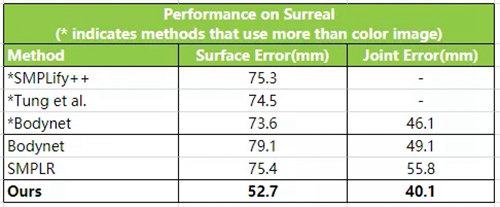

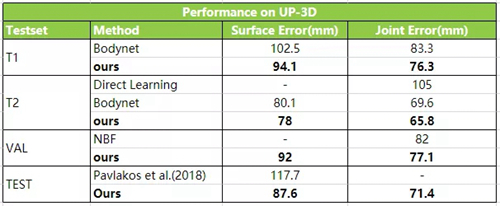

此次云从科技在3D人体数据集Human3.6M、Surreal和UP-3D上均大幅超越世界纪录。该数据集是全球关于3D人体重建技术的权威榜单,加州大学伯克利、马普所、Amazon、宾夕法尼亚大学、北京大学、浙江大学、Microsoft Research、法国国家信息与自动化研究所、Adobe Research等知名企业、研究所、大学都在该榜单的竞争队列中。

云从科技的算法在Surreal上的surface error从75.4毫米降低到52.7毫米,3D joint error从55.8毫米降低到40.1毫米,Human3.6M上的3D joint error从59.9毫米降低到46.7毫米,算法的执行速度从之前的几十甚至上百毫秒降低到仅需5毫秒。

Human3.6M数据集上对比

Surreal数据集上对比

UP-3D数据集上对比

微信扫描二维码,关注公众号。