随着技术的迭代,人工智能正在快速从解决 “具体问题” 的弱人工智能向解决 “通用问题” 的强人工智能演进。

在这个过程之中,人工智能想要获得同人类一样的解决问题的能力,必须具备与人类相似的 “知识架构”。有了这个基础,人工智能不仅可以做到 “共情”,甚至可以对人类行为或事态的发展进行一定程度的 “预判”。

初窥预言 “水晶球”

10 月 15 日,来自北卡罗来纳大学教堂山分校的博士生雷杰在 arXiv 上传了一篇名为 “What is More Likely to Happen Next? Video-and-Language Future Event Prediction” 的预印本论文,这篇论文的内容提出并初步实现了让 AI 预测事态未来,目前该论文已经被 EMNLP2020 接收。

雷杰告诉 DeepTech,前几年业内关注的研究重点都在于机器如何 “理解” 视频的内容,而他们的工作对于业内来说算是在新领域进行了些许拓荒,为加强和测试模型的事件预测能力及常识认知能力提供了一个新的方向。

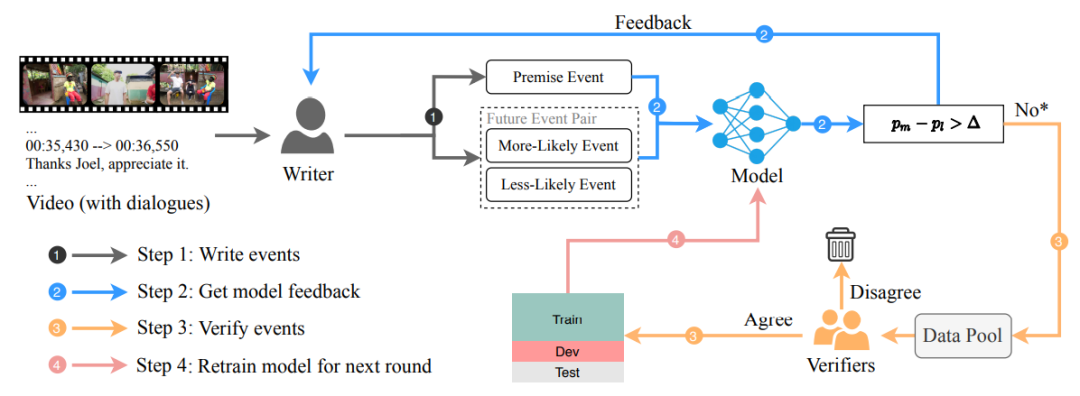

他们的项目名为 “VideoLanguageFuturePrediction”,其中 Video 指视频,而 Language 指视频中对话的文本,可以理解为 “字幕”。一次完整的预测流程大概是这样:

将视频 + 字幕 + 两种人类给出的未来可能方向 A 和 B,输入模型,模型将输出它的判断结果,即 A 和 B 各自发生的概率。通过这种做 “选择题” 的方式实现一定程度的 “预测”。

图 | VideoLanguageFuturePrediction 数据流程图

雷杰补充道,这是一种比较初步的解决方案,未来 AI 将能够做 “阅读理解”,即直接从给定的视频和字幕之中自己生成对未来的预测。当然,不管是 “选择题” 还是 “阅读理解”,都需要 AI 具备一定的理解能力。

同时,雷杰和同事也暂未加入让 AI 给出决策理由的功能。他说,这项能力可以单独作为一个比较复杂的研究课题,所以他们暂时聚焦于 “预测” 这件事。

为了训练这个模型,雷杰和同事准备了 2.8 万个用例,并将其命名为 “VLEP(Video-and-Language Event Prediction)”。

这批视频数据分成两类,电视节目以及来自 YouTube 的 Vlog。

图 | 视频素材统计

他们首先将这些视频进行预处理,最终它们被切割为一个个 60 到 90 秒的片段。之后将这批素材提交到数据标注平台进行人工标注。人类将标注短视频内 “事件” 的起止时间,并且给出两个预测结果 —— 未来较大可能发生的和较小可能发生的。

雷杰说,假如视频中显示一个人拿起杯子,那么按照常理推断,他更可能要喝水,而不是将杯子摔碎。“这种人类非常容易完成的事情,对机器来说并不简单。”

未来,他们将尝试结合大规模视频数据进行一些无监督学习,让模型能够加深对视频和字幕的理解,并建立像人类一样的 “关联”。

谈及应用,雷杰坦言,目前他们的研究仍然处于比较早期的阶段,但他认为未来人工智能必将具备同人类一样的 “知识架构”,它们将更加懂得人类的想法,同人类的合作也会更加 “心有灵犀”。

更喜欢 “确定性”

雷杰 2013 年考入坐落于成都的电子科技大学,大学二年级他凭借优异成绩入围了仅接收年级前 5% 学生的 “英才实验学院”,在这里,雷杰接受了较同龄人更为全面、系统性的计算机教育。

虽然他现在的研究方向专攻 “人工智能”,但其实雷杰最早报考的是微电子专业,入学之后才转到了计算机。

对此他解释道,“小的时候我非常喜欢鼓捣电子元器件,所以高考选择了这个专业,但当我设计的正确电路因为粗糙的工艺而失效时,我的内心动摇了。” 经过一段时间的自我审视,他发现自己更加倾向于 “1 + 1 = 2” 这类严格规整、且确定性的东西,便义无反顾地投身到计算机科学之中。

大一结束时,雷杰在同一位博士学长交流的过程中第一次听到了 “机器学习” 这个概念,这让他感到非常震惊。是的,机器为什么不能 “学习” 呢?

在好奇心的驱使下,他开始孜孜不倦地学习相关知识,并最终选择留学攻读相关领域的博士学位。